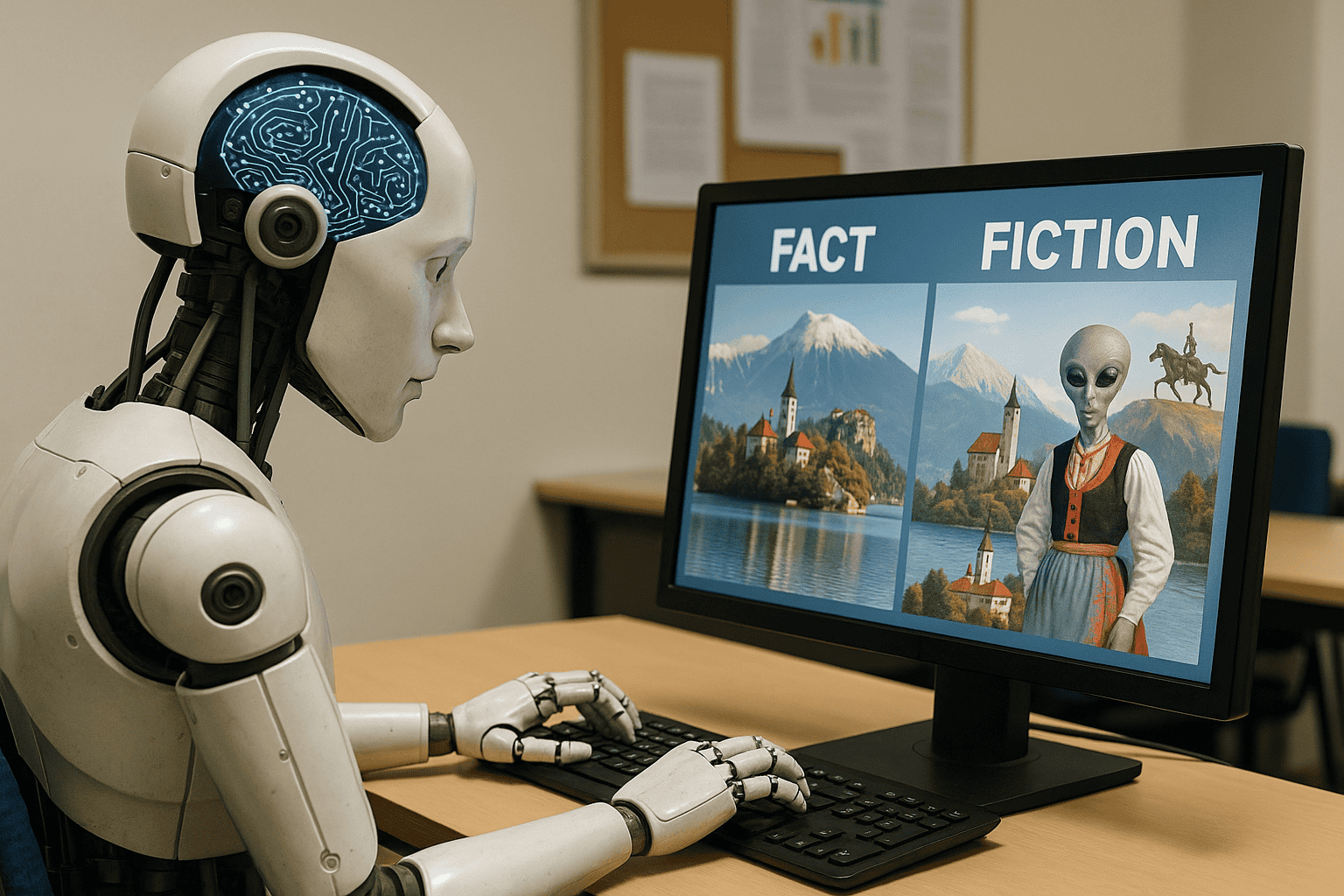

Halucinacije umetne inteligence so postale eden najbolj izpostavljenih problemov ob razmahu generativnih modelov. Gre za pojav, ko UI ustvari izdelek, ki je na prvi pogled povsem prepričljiv, v resnici pa popolnoma napačen ali celo izmišljen. O tem priča primer, ko je UI sistem generiral besedilo, ki je brezhibno opisovalo neobstoječi zgodovinski dogodek ali pa ustvaril fotografijo slovenskega Triglava s podobo vesoljca v narodnih nošah. Takšne napake niso zgolj zabavne, ampak lahko postanejo nevarne.

Kaj povzroča halucinacije UI in zakaj niso redke

Do halucinacij pogosto pride zaradi napačnih spodbud v postopku učenja. Modeli so pogosto trenirani tako, da jim je bolj pomembna samozavest in tekočnost odgovora kot dejanska resničnost podatkov. Ko uporabnik vpraša za podatke o, na primer, izmišljenem slovenskem pesniku, bo model raje izumil ime in nekaj verodostojnih dejstev, kot priznal, da ne ve. Enako velja za slikovne modele – rezultat je lahko denimo posnetek, ki prikazuje Blejsko jezero s piramido sredi otoka.

Halucinacije pa niso le posledica zasnove nagrajevanja. Pomembno vlogo imajo tudi omejeni in pristranski učni podatki. Če slovenski sistemi, kot je denimo pogovorni vmesnik za javne storitve ali chatbot v banki, niso trenirani na dovolj raznolikih in preverjenih podatkih, bodo hitro generirali neresnične vsebine. K temu dodatno prispeva dejstvo, da sodobni modeli nimajo občutka za zdravo pamet ali ne poznajo kontrole nad logičnimi povezavami. To pomeni, da lahko iz niza podatkov sklepajo napačne zaključke ali pa sestavijo vsebine, ki so povsem neverjetne.

V Sloveniji so se halucinacije že pojavile v praksi. Eden slovenskih ponudnikov avtomatskih prevodov je generiral prevod pravnega besedila, kjer je UI izumila zakon, ki v resnici ne obstaja. Drug primer je izobraževalni sistem, kjer je orodje za generiranje povzetkov podalo napačna dejstva o zgodovini Ljubljane. Te napake niso redke in kažejo, da slovenski uporabniki niso izvzeti iz globalnih izzivov umetne inteligence.

Kako se slovenska podjetja in raziskovalci spopadajo s halucinacijami

Slovenska podjetja, kot sta na primer Alpineon in Zemanta, se čedalje bolj posvečajo vprašanju zanesljivosti umetne inteligence. Raziskovalci na Institutu Jožef Stefan so razvili metode za preverjanje resničnosti podatkov, ki jih generirajo UI sistemi. Takšni pristopi vključujejo uporabo dodatnih preverjanj in primerjavo generiranih podatkov z zanesljivimi viri. S tem se zmanjšuje tveganje, da bi halucinacije zašle v resnične aplikacije, kot so medicinski pomočniki ali pravna orodja.

Strokovnjaki poudarjajo pomen kakovostnih učnih podatkov in tesnega sodelovanja z lokalnimi strokovnjaki, ki prepoznajo in popravijo napake v vsebinah, ki jih ustvari umetna inteligenca. V nekaterih slovenskih bankah že uporabljajo dodatne kontrolne mehanizme, kjer UI odgovore pregledujejo človeški svetovalci. Podobni ukrepi se uvajajo tudi v medijih, kjer so generirane novice najprej podvržene uredniškemu pregledu.

Vendar pa ostaja največji izziv, kako zagotoviti odgovorno uporabo UI v vsakodnevnih slovenskih aplikacijah. Potrebna bo večja transparentnost pri razvoju modelov in vključevanje več disciplin, od jezikoslovcev do pravnikov, ki lahko opozorijo na napake. Poleg tega je bistveno, da uporabniki razvijejo kritičen odnos do vsebin, ki jih ponuja umetna inteligenca, ter zahtevajo jasna pojasnila in možnost preverjanja podatkov.

Prihodnost in poziv k odgovornemu razvoju UI v Sloveniji

Halucinacije umetne inteligence ostajajo resen izziv, ki ga ni mogoče odpraviti čez noč. Kljub napredku tehnologije primeri iz slovenskega okolja kažejo, da je previdnost nujna pri vsakodnevni uporabi teh orodij. Napake umetne inteligence niso samo tehnični problem, ampak družbeni izziv, ki zahteva sodelovanje razvijalcev, uporabnikov in državnih institucij.

Slovenska podjetja in raziskovalci pomembno prispevajo k razumevanju in reševanju problema halucinacij, a ključna ostaja odgovornost pri implementaciji in uporabi UI. Priložnosti za inovacije so velike, vendar le ob ustreznih varovalkah, rednem preverjanju rezultatov in odprtem dialogu z javnostjo lahko tehnologiji zaupamo tudi v najbolj občutljivih okoljih.

Prihodnost UI v Sloveniji bo odvisna od tega, ali bomo znali prepoznati in nasloviti nevarnosti lažnih vsebin ter zagotoviti, da umetna inteligenca dela v korist ljudi. Čas je za odprto razpravo o odgovornem razvoju in uporabi UI, kjer je zanesljivost podatkov na prvem mestu.