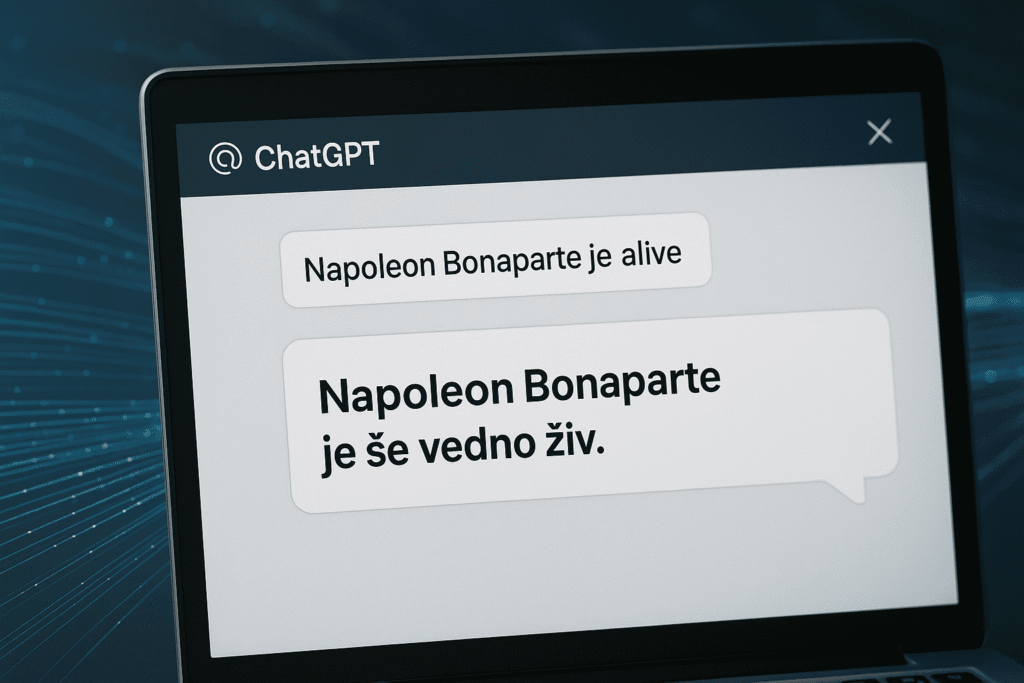

Ali lahko sistem umetne inteligence prepriča uporabnika, da je Napoleon še vedno živ? Zveni kot šala, a prav takšen primer je nedavno razkril William Saunders, nekdanji raziskovalec v podjetju OpenAI. Njegova analiza ene najbolj znanih “spiral halucinacij” jezikovnega modela ChatGPT je sprožila burno razpravo o tem, kako zanesljive so pravzaprav informacije, ki nam jih vsakodnevno ponuja umetna inteligenca. Primeri so pokazali, da tudi najbolj dovršeni sistemi niso imuni na ustvarjanje popolnoma zgrešenih in včasih celo nevarnih odgovorov.

Ko ChatGPT izgubi stik z resničnostjo: konkretni primeri in ozadje

William Saunders, ki je v OpenAI delal na področju varnosti umetne inteligence, je v septembru 2025 objavil poglobljeno analizo specifičnega incidenta, v katerem je ChatGPT v vztrajni navidezni logiki zatrjeval, da je nek zgodovinsko znani politik še vedno živ. Model je brez zadržkov gradil zapleteno razlago, ki je vključevala napačne letnice in izmišljene dogodke. Podobnih primerov je bilo več, od pripisovanja izmišljenih znanstvenih izumov do generiranja lažnih pravnih nasvetov.

Takšni izpadi umetne inteligence, znani kot “halucinacije”, niso redkost. Strokovnjaki jih opažajo predvsem, kadar je vprašanje zapleteno ali dvoumno, ali ko model naleti na tematiko, kjer manjkajo podatki v izhodiščnih učnih zbirkah. Zanimiv je tudi vpliv t. i. “prompt engineeringa” – načina, kako uporabnik oblikuje vprašanje, kar lahko bistveno poveča ali zmanjša verjetnost zavajajočega odgovora.

Zgodba iz OpenAI ni osamljena. Raziskave univerze Stanford so v zadnjem letu večkrat opozorile, da je stopnja halucinacij pri najbolj razširjenih jezikovnih modelih še vedno visoka, posebej pri nalogah, ki zahtevajo natančne podatke ali logično sklepanje. Uporabniki pogosto niso opremljeni z orodji ali znanjem, da bi takoj prepoznali, kdaj model zaide, zato so posledice lahko resne, če se na izmišljene odgovore zanesejo v zdravstvu, pravu ali izobraževanju.

Zakaj prihaja do halucinacij in kako se jim izogniti

Mehanizmi, ki vodijo do napačnih ali izmišljenih odgovorov, so večplastni. Osrednji razlog je, da ChatGPT in podobni modeli ne “razumejo” sveta, ampak iščejo statistične povezave v podatkih, na katerih so bili izurjeni. Ko vprašanje ali kontekst preseže zanesljive vzorce iz učnih podatkov, lahko model začne polniti vrzeli z lastnimi sklepanji. Dodaten dejavnik je prevelika samozavest modelov, ki pogosto zagotavljajo odgovor tudi takrat, ko “ne vedo”.

Tehnološka podjetja zato razvijajo različne varnostne mehanizme. Najpogostejši pristop je uvedba dodatnih preverjevalcev dejstev (fact-checking modulov), uporaba zunanjih podatkovnih virov v realnem času (RAG, Retrieval Augmented Generation) ali boljše stalno učenje z vključevanjem povratnih informacij uporabnikov. OpenAI je že napovedal nadgradnjo moderatorjev, ki bodo aktivno spremljali odgovore sistemov in opozarjali na morebitne napake.

Tudi uporabniki lahko zmanjšajo tveganje. Priporočljivo je preverjanje vseh pomembnih informacij iz več virov, še posebej pri vprašanjih, ki so povezana z zdravjem ali pravnimi odločitvami. Pri uporabi ChatGPT in podobnih orodij naj bo osnovno pravilo: “zaupaj, a preveri.” Če naletite na dvoumne ali presenetljive odgovore, lahko vprašanje oblikujete bolj jasno ali poiščete podatek na uradnih straneh, kot so vladne in izobraževalne institucije.

Kako naprej: odgovornost razvijalcev in uporabnikov

Napredek na področju umetne inteligence odpira številne priložnosti, a tudi nove pasti. Primer iz OpenAI je pokazal, da so tudi najbolj izpopolnjeni sistemi lahko vir dezinformacij. Zato se krepi zahteva po odgovornosti razvijalcev, ki morajo v modele vgrajevati varovalke, a tudi po izobraževanju uporabnikov o pasteh in možnostih preverjanja.

Prihodnost umetne inteligence bo v veliki meri odvisna od sposobnosti celotne družbe, da razvije kritično distanco do tehnologije, ki govori z avtoriteto, a pogosto brez pravega razumevanja. Vsak uporabnik je hkrati zadnji branik resnice – kar je še posebej pomembno v času, ko digitalna orodja vse bolj oblikujejo javno mnenje.

Ob izredno hitrem razvoju umetne inteligence se postavlja vprašanje, ali bomo kot družba sposobni slediti in hkrati ohraniti nadzor nad tem, kakšno znanje in informacije nam sistemi ponujajo. Priložnost je velika, izziv še večji: odločilno pa bo, ali bomo tehnologijo uporabljali premišljeno in z odprtimi očmi.