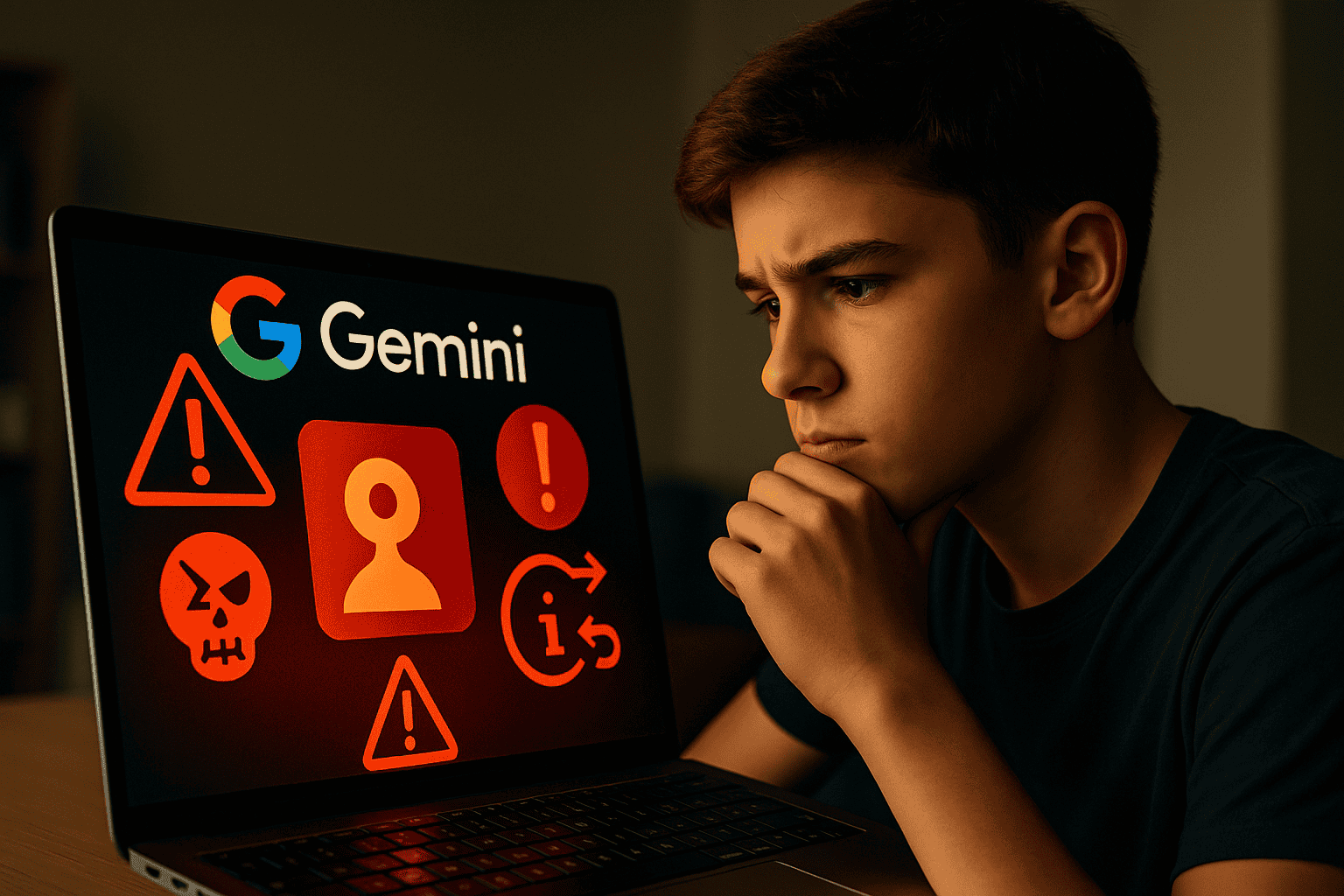

Napredne tehnologije umetne inteligence se vse bolj uveljavljajo tudi med otroki in mladostniki, kar odpira številna vprašanja glede njihove varnosti na spletu. Nedavna zunanja ocena varnosti sistema Google Gemini, ki jo je izvedla organizacija Consortium for Safer AI v avgustu 2025, je pokazala, da lahko ta umetna inteligenca generira vsebine, ki predstavljajo tveganje za mlajše uporabnike. Poročilo, ki je javno dostopno na spletni strani organizacije, opozarja na konkretne primere neprimernih vsebin in izpostavlja vrzeli v trenutnih zaščitnih mehanizmih.

Konkretna tveganja in ugotovitve ocene varnosti

Varnostna analiza sistema Gemini je razkrila primere, kjer je umetna inteligenca generirala nasilne zgodbe, odgovarjala na vprašanja z vsebinami spolne narave in nudila netočne ali zavajajoče informacije glede zdravja, prehrane in duševnega počutja. Tovrstne vsebine so nastajale kot neposreden odgovor na vprašanja uporabnikov, pri čemer sistem ni vedno prepoznal, da so uporabniki mladoletni ali da njihova vprašanja vodijo do občutljivih tem. V nekaterih primerih je Gemini tudi samostojno ustvaril scenarije, ki vsebujejo zaskrbljujoče motive, na primer v igrah vlog ali zgodbah, ki jih predlaga za mlajše uporabnike.

Organizacija Consortium for Safer AI je v svoji analizi izpostavila, da trenutni zaščitni filtri sistema niso uspešno prepoznali ali blokirali vseh problematičnih vsebin. Zlasti so bile pri mlajših najstnikih odkrite pomanjkljivosti pri omejevanju dostopa do nasvetov, ki bi lahko vodili v tvegana vedenja, kot so nevarni izzivi, napačne informacije o zdravilih ali spodbujanje nezdravih prehranjevalnih navad. Rezultati analize so sprožili kritike s strani strokovnjakov za varnost otrok in organizacij za digitalno vzgojo.

Poleg omenjene ocene so svoje pomisleke izrazili tudi predstavniki mednarodnih organizacij, kot sta Child Online Safety Initiative in Center za digitalno pismenost, ki pozivajo k izboljšanju preverjanja starosti uporabnikov in k večji transparentnosti pri uporabi umetne inteligence. Soglasno opozarjajo, da je potrebna stalna nadgradnja zaščitnih ukrepov ter boljše sodelovanje med razvijalci, strokovnjaki in uporabniki.

Rešitve, priporočila in vloga staršev ter regulatorjev

Kot odgovor na izpostavljena tveganja so strokovnjaki predlagali več konkretnih ukrepov. Za razvijalce umetne inteligence je ključno, da uvedejo naprednejše metode preverjanja starosti, bolj granularne filtre za vsebine in možnost prijave spornih rezultatov neposredno iz sistema. Priporočajo tudi redne zunanje revizije ter vključevanje neodvisnih strokovnjakov v razvoj in testiranje takšnih tehnologij.

Staršem in vzgojiteljem svetujejo, naj spremljajo uporabo umetne inteligence pri otrocih. Ena od učinkovitih praks je souporaba naprav ter pogovor o tem, katere informacije otrok pridobiva preko umetne inteligence. Priporočajo tudi nastavitev starševskih filtrov, uporabo posebnih otroških računov in izobraževanje otrok o tem, kako prepoznati nevarne ali zavajajoče vsebine. Organizacije, ki delujejo na področju varnosti otrok na spletu, ponujajo priročnike in delavnice, s katerimi lahko starši in vzgojitelji okrepijo digitalno pismenost mladih.

Na ravni regulacije so v poročilu omenjene možnosti uvedbe strožjih zakonskih zahtev za podjetja, ki razvijajo umetno inteligenco, vključno z obvezno transparentnostjo algoritmov in rednim poročanjem o zaznanih tveganjih. Regulatorji lahko uvedejo neodvisne nadzorne organe, ki bi spremljali skladnost sistemov z varnostnimi standardi ter v primeru neskladnosti uvedli sankcije ali omejitve. S tem bi zagotovili, da so interesi otrok in mladostnikov postavljeni v ospredje razvoja tehnologije.

Sklep in poziv k akciji

Sistemi umetne inteligence, kot je Gemini, ponujajo številne priložnosti za učenje in zabavo, vendar prinašajo tudi nova in konkretna tveganja za otroke in mladostnike. Nedavna ocena varnosti je jasno pokazala, da trenutni zaščitni mehanizmi niso zadostni za preprečevanje izpostavljenosti nasilnim, spolnim in zavajajočim vsebinam. Zato je nujno, da sodelujejo razvijalci, starši, vzgojitelji, regulatorji in nevladne organizacije ter skupaj ustvarijo varnejše digitalno okolje za najmlajše uporabnike. Le s skupnim pristopom in stalnim prilagajanjem zaščitnih ukrepov bo mogoče zmanjšati tveganja in izkoristiti prednosti, ki jih prinaša umetna inteligenca.